前言

最近决定学一些大数据、分布式之类的技术。其中最基本的比如说安装Hadoop,没想到安装个这个也不太顺利,这里简单记录一下。

主要参考的两篇教程:

注意:本文将介绍伪分布式安装过程,至于真分布式不做介绍。

搭建流程

1 安装java

略

2 下载Hadoop

3 找到Java安装路径

which java定位到的是java程序的执行路径,而不是安装路径,经过两次-lrt最后的输出才是安装路径。

具体参考第2篇文档。

4 安装Hadoop

上面两篇文档放置的Hadoop的位置路径不同,一个是在/home/路径下,一个是在usr/local/hadoop下,而我自己选择了/opt下面。

相关不同可以参考:Linux 软件安装到 /usr,/usr/local/ 还是 /opt 目录?_LSGOZJ的博客-CSDN博客

5 设置Hadoop启动项

同样的,上面两篇教程中配置方式也不相同,一篇直接修改/etc/profile,一篇修改/etc/profile.d/hadoop.sh,两者殊途同归,效果一致。

内容大致即:

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.242.b08-0.el7_7.x86_64

export HADOOP_HOME=/home/hadoop-3.2.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

然后使配置生效刷新环境变量,即运行source /etc/profile

6 创建hadoop用户

adduser hadoop # 新增用户

passwd hadoop # 设置秘密

groupadd hadoop # 新建用户组

usermod -G hadoop hadoop # 将用户添加到用户组

id hadoop # 查看用户情况

7 创建hadoop文件目录并授权

mkdir -p /home/hadoop/tmp # hadoop临时文件目录

mkdir -p /home/hadoop/hdfs/name # hadoop主节点(namenode)文件目录

mkdir -p /home/hadoop/hdfs/data # hadoop数据节点(datanode)文件目录

mkdir -p /home/hadoop/log # hadoop日志文件目录

chown -R hadoop:hadoop /home/hadoop # 设置hadoop文件目录所有者

8 修改hadoop配置文件

hadoop的配置文件都在 etc/hadoop 目录下,配置文件有很多,最基本要修改3个文件:hadoop-env.sh ,core-site.xml,hdfs-site.xml。

8.1 hadoop-env.sh

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.242.b08-0.el7_7.x86_64 # 需要指定Java路径

export HADOOP_LOG_DIR=/home/hadoop/log # 需要指定hadoop_log_dir

8.2 core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

<description>hdfs内部通讯访问地址</description>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/home/hadoop/tmp</value>

<description>hadoop数据存放</description>

</property>

</configuration>

8.3 hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/home/hadoop/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/home/hadoop/hdfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

9 设置ssh免密登录

注意:以下命令均是在hadoop用户下进行。

需要用前面创建的hadoop用户通过ssh免密访问本地,先切换到hadoop用户目录下,执行以下命令:

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

测试是否成功,执行下面命令,若不用输入密码则成功。

ssh localhost

10 启动hadoop

注意:以下命令均是在hadoop用户下进行。

10.1 格式化hadoop文件系统

hdfs namenode -format

10.2 一键启动

start-all.sh

10.3 检验

输入命令 ,没有报错,则hadoop单机版安装成功。

hadoop fs -ls /

11 查看启动效果

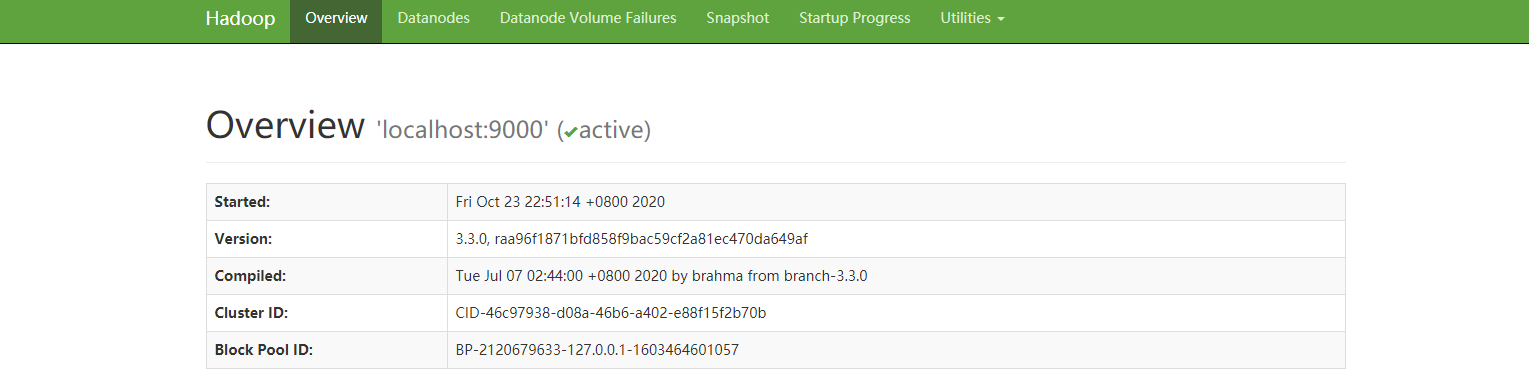

访问http://localhost:9870,可以得到如下图所示: